ETRI, 초대형 AI 학습 ‘메모리 장벽’ 해결

기사입력 2026.01.08 13:25

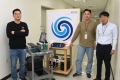

▲옴니익스텐드 기술을 개발한 ETRI 연구진(좌측부터 차승준 박사, 김강호 본부장, 석성우 박사, 고광원 실장)

이더넷 기반 메모리 확장 기술 개발, GPU 메모리 부족 해소·LLM 성능 2배 향상

한국전자통신연구원(ETRI)이 초대형 인공지능(AI) 학습 과정에서 가장 큰 난제로 꼽혀온 GPU 메모리 부족 문제를 근본적으로 해결할 기술을 개발했다.

ETRI는 초대형 AI 학습에서 가장 큰 문제로 꼽히는 GPU의 메모리 한계와 데이터 병목 현상을 해결하는 새로운 메모리 기술 ‘옴니익스텐드(OmniXtend)’를 개발했다고 8일 밝혔다.

ETRI가 개발한 옴니익스텐드는 표준 이더넷(Ethernet)을 활용해 여러 장비의 메모리를 공유 메모리 풀(memory pool)로 구성하는 기술이다.

이를 통해 AI 학습에 필요한 메모리를 원하는 만큼 유연하게 확장할 수 있으며, 기존 장비를 교체하지 않고도 대규모 메모리 환경을 구축할 수 있다.

ETRI는 옴니익스텐드를 적용한 실험에서 메모리 부족으로 성능이 저하된 LLM 추론 환경이 최대 2배 이상 성능을 회복했다고 밝혔다.

이는 충분한 메모리를 갖춘 기존 시스템과 유사한 처리 성능을 확보할 수 있음을 의미한다.

또한 기존 PCIe 기반 확장 구조는 장비 간 연결 거리와 확장성에 한계가 있었지만, 옴니익스텐드는 이더넷 스위치를 활용해 물리적으로 떨어진 장비까지 하나의 메모리 풀로 묶을 수 있는 고확장성 구조를 제공한다.

초대규모 AI 데이터센터에 적합한 인프라로 평가받는 이유다.

ETRI 연구진은 △FPGA 기반 메모리 확장 노드 △이더넷 기반 메모리 전송 엔진 등 핵심 요소기술을 개발해 시스템의 안정적 동작을 검증했다.

실제 시연에서는 여러 장비가 네트워크를 통해 실시간으로 서로의 메모리에 접근하는 모습을 성공적으로 구현했다.

또한 옴니익스텐드는 지난해 프랑스 파리와 미국 샌타클라라에서 열린 RISC-V 서밋 유럽·북미 행사에서 연이어 공개되며 국제적 관심을 받았다.

ETRI는 리눅스 재단 산하 CHIPS Alliance의 인터커넥트 워킹 그룹을 주도하며 오픈소스 기반 메모리 확장 표준화에도 기여하고 있다.

ETRI는 향후 데이터센터 하드웨어·소프트웨어 기업을 중심으로 기술이전을 추진해 상용화를 본격화할 계획이다.

특히 AI 학습·추론 서버, 메모리 확장 장치, 네트워크 스위치 등 다양한 장비에 적용해 차세대 AI 인프라 시장에서 실질적 산업 성과 창출을 목표로 하고 있다.

또한 차량·선박 등 고신뢰 임베디드 시스템의 대용량 메모리 연결망으로 기술을 확장하고, NPU·GPU·CPU 등 이종 가속기 간 메모리 공유 구조를 고도화하는 후속 연구도 추진할 예정이다.

ETRI 김강호 초성능컴퓨팅연구본부장은 “NPU 중심의 메모리 인터커넥트 기술 연구를 확대해 글로벌 AI·반도체 기업의 차세대 시스템에 적용될 수 있도록 국제 협력을 강화하겠다”고 밝혔다.

이번 연구는 과학기술정보통신부와 정보통신기획평가원(IITP)의 ‘메모리 중심 차세대 컴퓨팅 시스템 구조 연구’ 과제의 지원을 받아 수행됐다.

관련 웨비나

많이 본 뉴스

[열린보도원칙] 당 매체는 독자와 취재원 등 뉴스이용자의 권리 보장을 위해 반론이나 정정보도, 추후보도를 요청할 수 있는 창구를 열어두고 있음을 알려드립니다.

고충처리인 장은성 070-4699-5321 , news@e4ds.com

.jpg)

.png)